IPBench:揭秘大语言模型在知识产权领域的知识边界

🌐 项目主页 | 🤗 数据集下载 | 📂 GitHub仓库

为什么需要专门的知识产权AI评测基准?

在专利审查、技术查新、法律咨询等知识产权服务场景中,专业知识的准确性和法律条款的严谨性至关重要。现有大语言模型(LLM)虽然在通用领域表现出色,但在处理专利权利要求解释、技术特征比对等专业任务时仍存在明显短板。

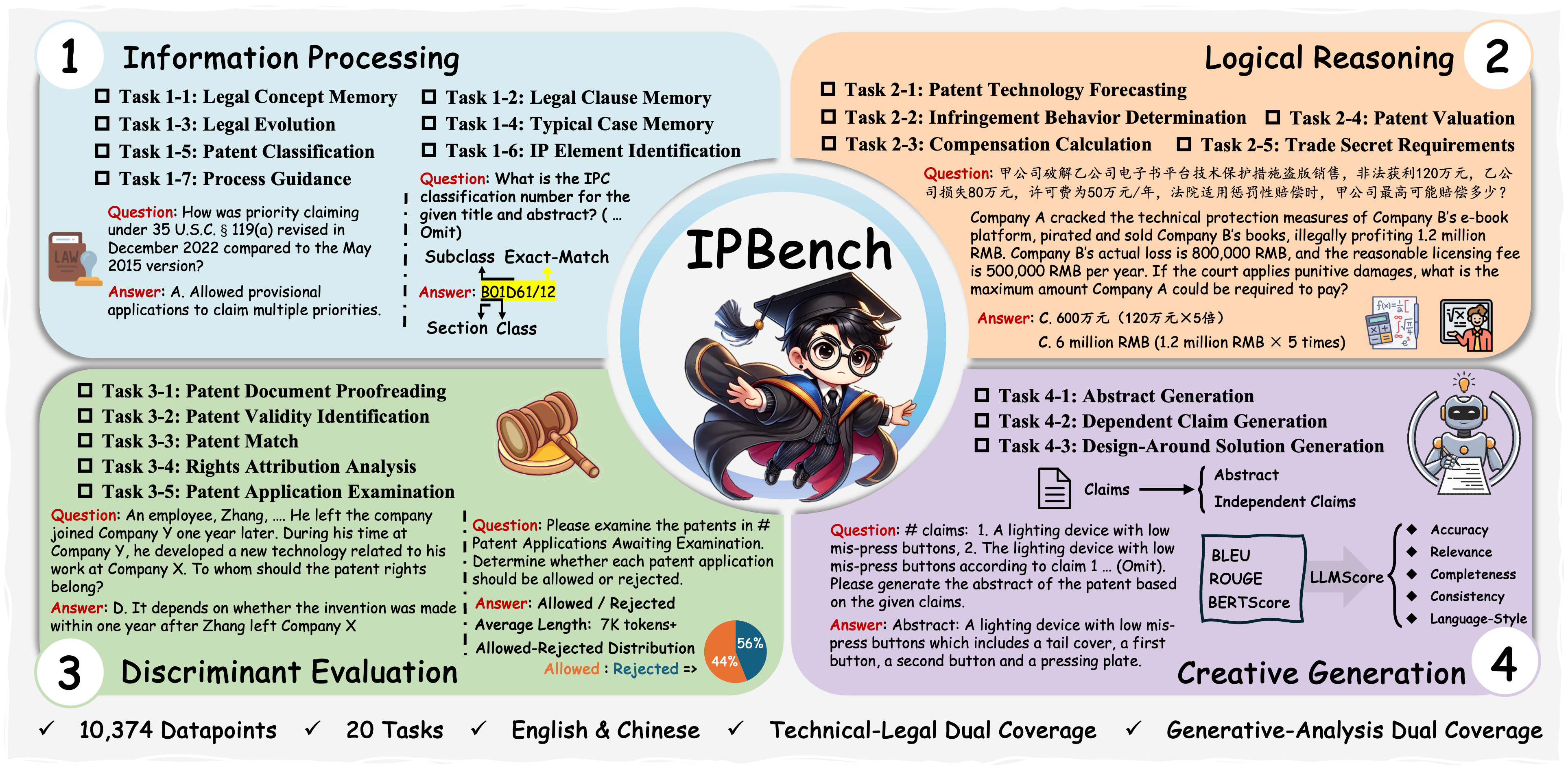

IPBench研究团队基于Webb知识深度理论,构建了包含4个认知层级的评测框架:

-

信息处理:专利文献的要素提取与分类 -

逻辑推理:技术方案的权利要求范围界定 -

判别评估:侵权判定与技术新颖性分析 -

创新生成:技术交底书的自动撰写

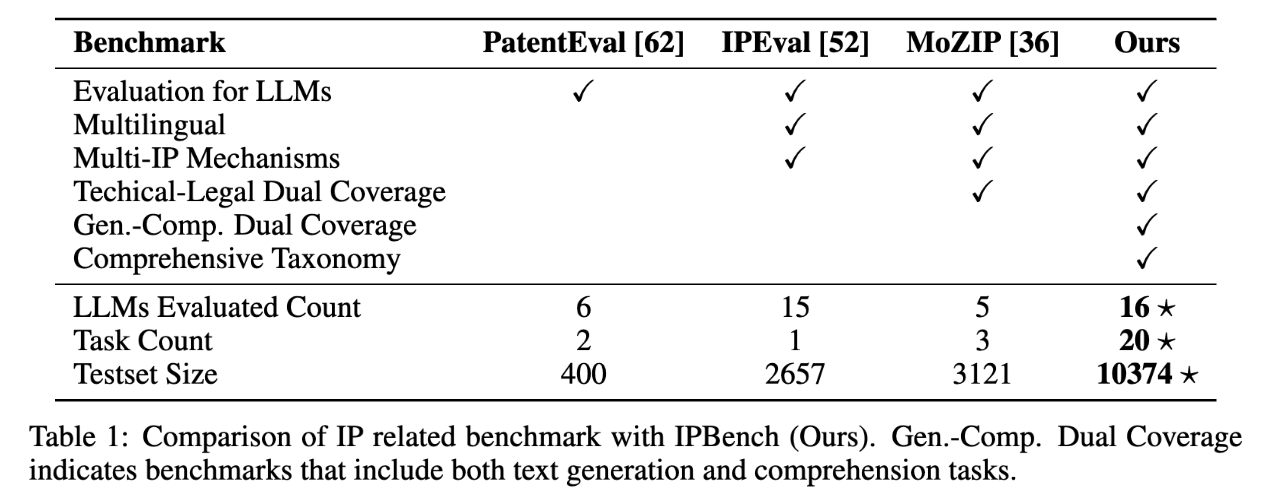

通过覆盖中美两国法律体系的10,374个双语测试样本,该基准可系统评估模型在8类知识产权机制下的20项核心能力。

三大技术突破解析

突破一:多维度任务体系设计

与传统法律评测基准相比,IPBench首次实现了:

-

跨模态处理:同时支持文本、权利要求书、技术图纸的解析 -

动态知识更新:包含2020-2025年最新专利法规案例 -

区域法律适配:中美双语法律条款的对比测试

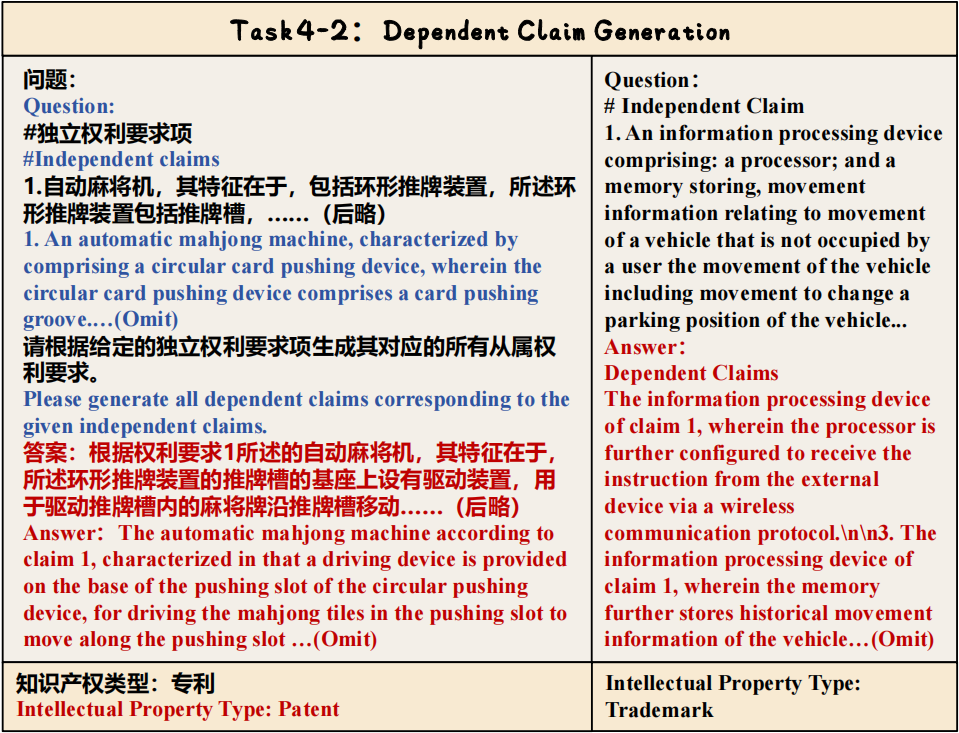

突破二:真实场景任务还原

从专利申请到侵权诉讼的全流程模拟测试中,包含以下典型任务示例:

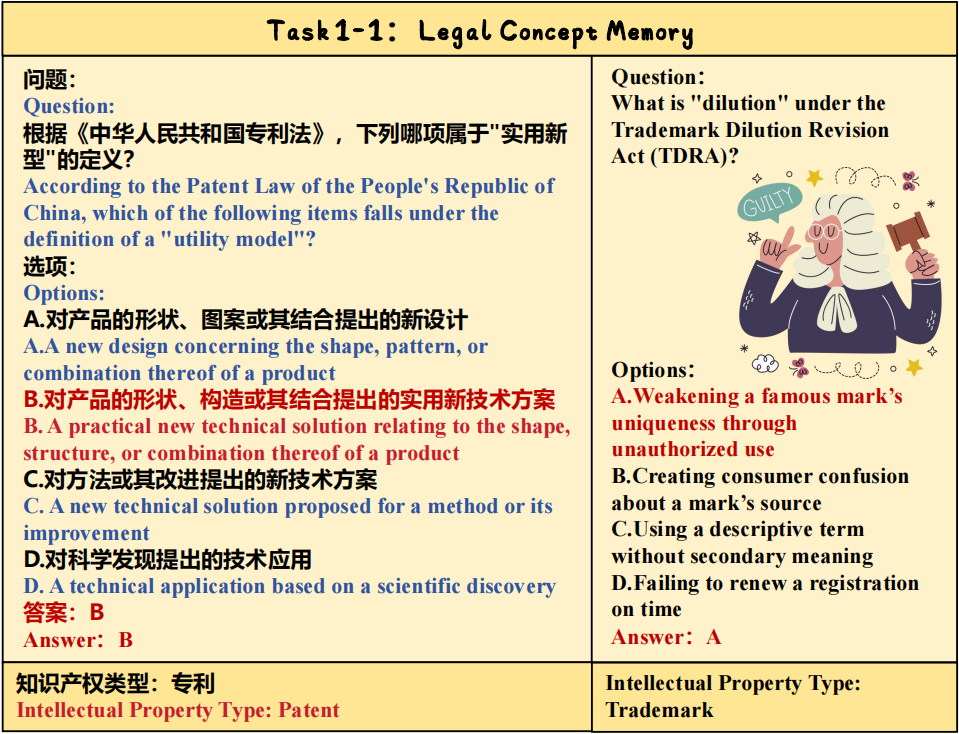

任务1-1:专利说明书的技术特征提取

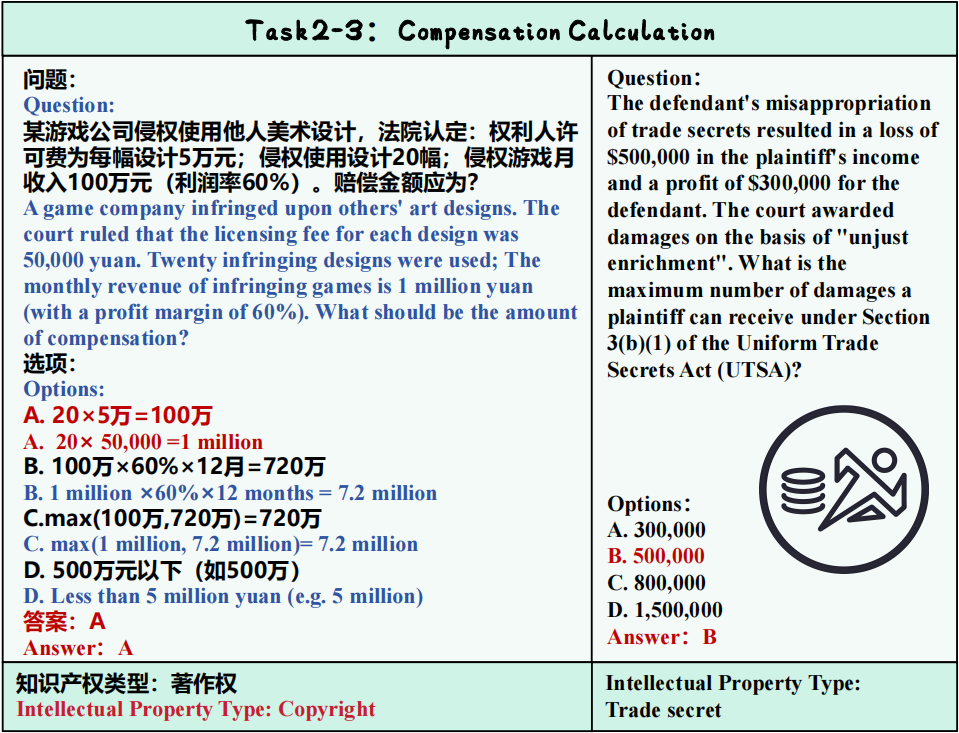

任务2-3:权利要求书的语义冲突检测

任务4-2:技术交底书的自动生成

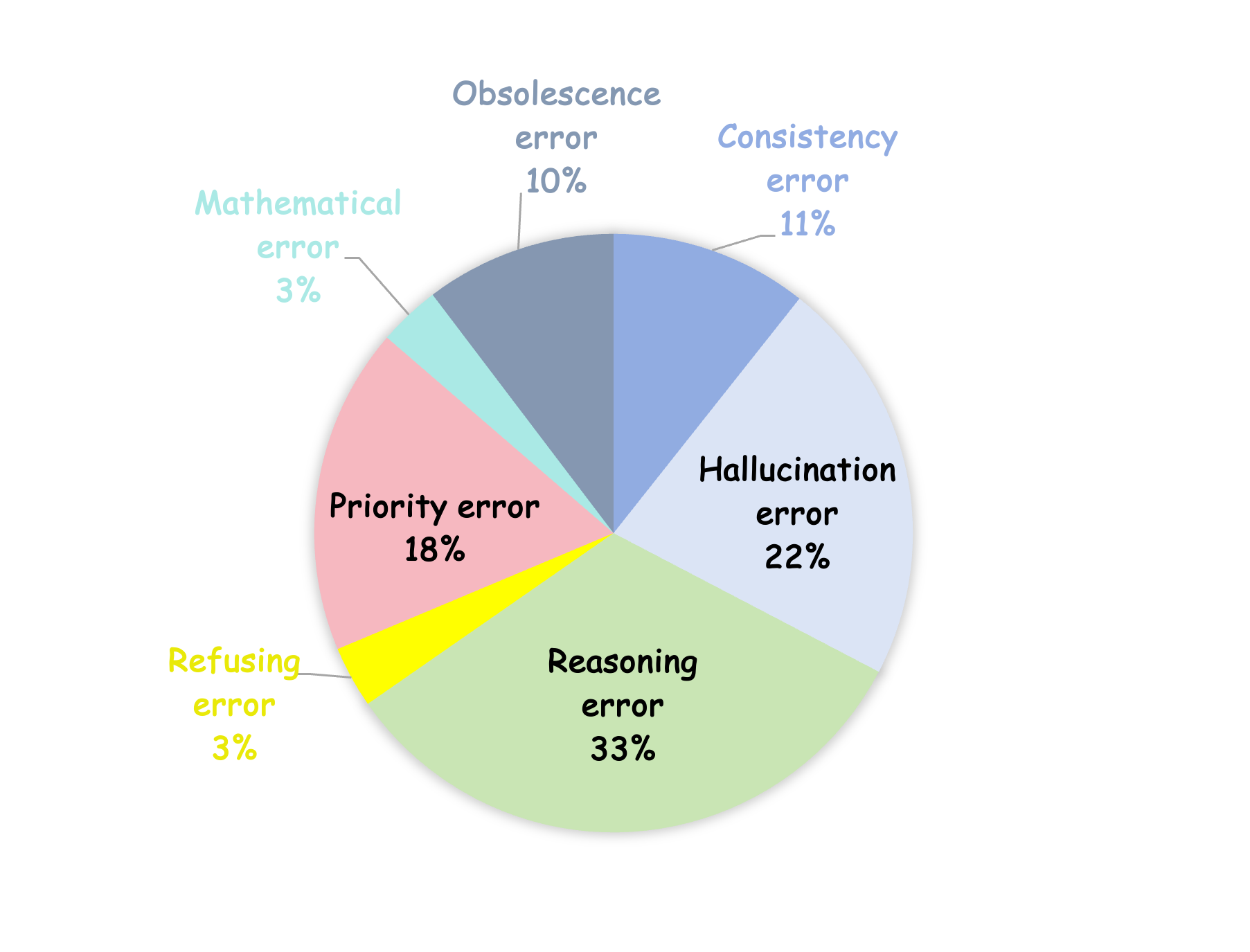

突破三:细粒度错误分析体系

通过300个GPT-4o错误样本的标注,建立了7大类错误类型:

-

逻辑推理错误(33%):技术特征因果关系误判 -

法律条款滞后(22%):未识别2024年专利法修订条款 -

技术特征混淆(18%):将”石墨烯涂层”误判为”碳纳米管结构”

快速使用指南

环境配置

# 安装依赖库

pip install -r requirements.txt

模型推理

提供三种测试模式:

# 零样本推理

sh inference.sh

# API接口测试(支持OpenAI格式)

sh inference-api.sh

# 思维链提示测试

sh inference-cot.sh

结果评估

# 选择题评估

sh eval-mcqa.sh

# 分类任务评估(3-5类)

sh eval-3-5.sh

# 生成内容评估

sh eval-generation.sh

实验结果揭示的四大发现

发现一:专业领域微调至关重要

测试显示,未经专利数据微调的通用模型平均准确率仅为54.3%,而经过IPC分类微调的模型可达78.6%。

发现二:中美法律差异显著

在”先用权抗辩”任务中,模型对中国法律条款的识别准确率(82%)明显高于美国条款(67%),反映出训练数据的地域偏向。

发现三:多步推理仍是痛点

涉及”创造性判断”的复合任务中,即使GPT-4o在思维链提示下的准确率也只有61.2%,主要错误集中在技术启示的组合判断。

发现四:生成任务质量参差不齐

在技术交底书生成任务中,模型产出存在两个极端:

-

格式规范性:得分89/100 -

技术细节准确性:得分仅42/100

给AI开发者的实践建议

数据增强策略

-

引入WIPO的PATENTSCOPE数据库百万级专利文献 -

构建”技术特征-法律条款”映射知识图谱 -

添加权利要求书修订历史数据

模型优化方向

-

开发法律条文版本控制模块 -

嵌入IPC国际分类编码器 -

设计技术特征相似度计算专用层

应用场景延伸

-

智能专利检索:精准匹配技术方案与现有专利 -

侵权风险预警:自动识别产品技术特征侵权可能性 -

审查辅助系统:生成审查意见通知书初稿

未来演进路线

研究团队透露下一步将:

-

扩展至欧盟、日本法律体系(2025Q4) -

增加图像权利要求解析模块(2026Q1) -

开发开源法律微调框架IP-Tuner(2026Q2)

学术资源索引

-

完整实验数据:Hugging Face数据集 -

技术白皮书:项目官网文档中心 -

学术合作联系:wangqiyao@mail.dlut.edu.cn

相关技术阅读:

深度解析专利权利要求书的语义结构

中美专利法核心差异对比表

技术交底书自动化撰写实践指南