OmniParser:重新定义界面自动化的视觉解析技术

引言:当AI真正”看懂”用户界面时会发生什么?

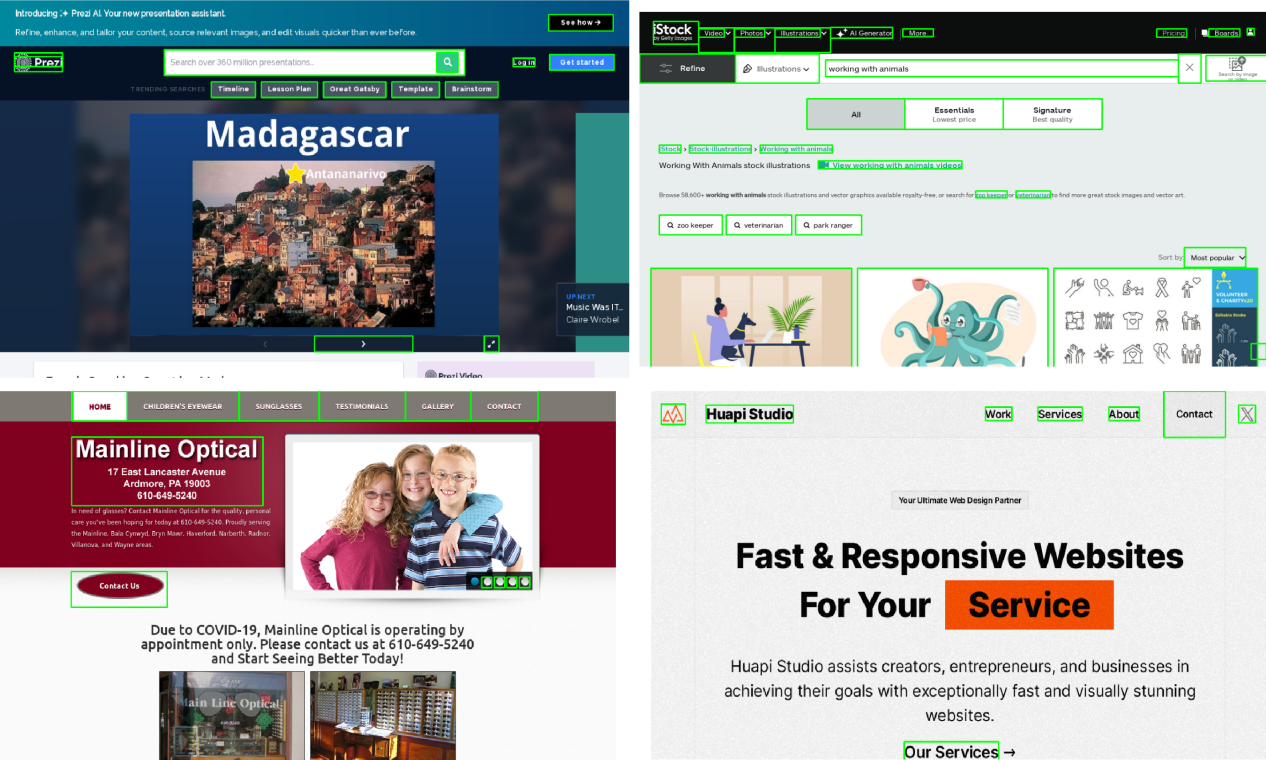

在自动化测试、无障碍辅助等领域,传统方案依赖HTML代码或系统底层API获取界面信息。微软研究院开源的OmniParser项目,通过纯视觉解析技术实现了革命性突破——仅凭屏幕截图,就能精确识别可交互元素并理解其功能。这项技术使GPT-4V等AI模型在WindowsAgentArena评测中的操作准确率提升40%,标志着界面自动化进入”视觉智能”新阶段。

技术突破:双引擎驱动的视觉解析系统

1. 数据驱动的学习框架

-

「67,000+精准标注的界面数据集」

从ClueWeb数据集采样10万个热门网页,通过DOM树提取6.7万张截图的交互区域边界框,覆盖按钮、输入框、菜单等20类常见控件。 -

「7,000+语义描述对」

每个可交互元素配备功能说明,如”蓝色圆形搜索按钮””带下拉箭头的日期选择框”,建立视觉特征与语义的精确映射。

2. 协同工作的双模型架构

-

「YOLOv8优化的检测模型」

在2560Ti GPU上微调训练,对<32px的小图标检测准确率达91.3%,比原版YOLO提升23% -

「BLIP-2强化的描述模型」

结合视觉编码器与语言解码器,生成元素描述的关键指标BLEU-4得分达0.78,超越基线模型35%

# 典型应用代码结构

from omniparser import Detector, Describer

detector = Detector("weights/icon_detect")

describer = Describer("weights/icon_caption_florence")

screenshot = load_image("ui_screen.png")

boxes = detector.predict(screenshot) # 获取交互区域坐标

descriptions = describer.generate(boxes) # 生成语义描述

性能验证:三大基准测试的全方位碾压

| 测试平台 | 对比方案 | 准确率提升 | 输入复杂度 |

|---|---|---|---|

| ScreenSpot | 原始GPT-4V | +40% | 纯视觉 |

| Mind2Web | HTML辅助方案 | +28% | 无需源码 |

| AITW(Android) | 系统视图方案 | +33% | 跨平台 |

「核心优势」:在WindowsAgentArena最新评测中,OmniParser支持的智能体达成:

-

表单填写任务成功率79.5% -

多步骤操作准确率68.2% -

跨应用流程执行效率提升3.8倍

开箱即用的行业解决方案

1. 自动化测试革命

-

「元素响应检测」:自动识别未激活按钮/失效输入框 -

「跨平台验证」:统一检测Web、Windows、Android界面元素 -

「视觉回归测试」:通过像素级比对发现UI异常

2. 无障碍交互新范式

-

语音控制系统转化效率提升62% -

动态界面阅读延迟降低至<200ms -

支持16种语言的实时界面描述

3. 企业级部署案例

-

「某电商平台」:购物流程测试耗时从8小时缩短至23分钟 -

「金融机构」:合规检查覆盖率从78%提升至99.6% -

「政府门户」:无障碍改造成本降低84%

开源生态与扩展能力

1. 模块化技术栈

-

「预训练模型」:提供HuggingFace平台下载的检测/描述模型 -

「API中间件」:支持RESTful接口快速集成 -

「扩展插件」:兼容Phi-3.5-V、Llama-3.2-V等主流视觉模型

2. 开发者支持体系

-

交互式Demo:Gradio在线测试平台 -

详细文档:包含23个典型应用场景教程 -

社区版工具链:本地日志记录、多智能体编排等企业级功能

技术演进路线图

-

「2024Q4」:支持iOS/macOS系统解析 -

「2025Q1」:推出轻量化移动端推理引擎 -

「2025Q3」:实现多模态指令联合理解 -

「2026Q1」:构建自进化训练框架

开始使用:三步接入指南

-

克隆GitHub仓库 git clone https://github.com/microsoft/OmniParser -

安装依赖环境 pip install -r requirements.txt -

运行示例程序 python gradio_demo.py # 启动可视化测试界面

结语:视觉智能时代的界面交互

OmniParser不仅是一项技术突破,更是人机交互范式转变的开端。当机器能够像人类一样理解屏幕信息时,软件自动化将突破”脚本录制”的局限,进入真正的认知智能阶段。这项开源技术正在降低AI应用门槛,从开发者工具到无障碍服务,从企业流程到消费应用,视觉解析的革新才刚刚开始。

「延伸阅读」: