随着大型语言模型(LLM)在应用开发中的普及,如何高效管理模型的上下文与工具集成成为开发者关注的核心问题。OpenAI近期推出的Agents SDK新增了对**模型上下文协议(Model Context Protocol, MCP)**的支持,这一功能为开发者提供了标准化的工具连接方案。本文将深入解析MCP的核心概念及其在Agents SDK中的实现。

什么是模型上下文协议(MCP)?

模型上下文协议(MCP)是一个开源的标准化协议,旨在解决AI应用与数据源、工具之间的连接问题。官方文档将其比喻为**“AI领域的USB-C接口”**——正如USB-C统一了设备与外围硬件的连接方式,MCP为LLM提供了统一的上下文管理框架。

MCP的核心价值

-

标准化工具接入:通过协议定义的工具接口,开发者可以快速集成文件系统、数据库、API服务等多样化工具。 -

动态上下文感知:每次运行代理(Agent)时,SDK会自动从MCP服务器获取最新工具列表,确保模型始终基于最新上下文决策。 -

跨平台兼容性:支持本地(stdio)与远程(HTTP over SSE)两种服务器类型,适应不同部署场景。

MCP服务器的类型与应用场景

MCP协议目前定义了两种服务器类型,开发者可根据需求选择适合的通信机制。

1. 本地stdio服务器

通过MCPServerStdio类实现,这类服务器以子进程形式运行在本地环境中。典型应用场景包括:

-

快速原型开发:结合文件系统工具(如官方提供的@modelcontextprotocol/server-filesystem),直接操作本地文件。 -

低延迟工具调用:适用于需要频繁访问本地资源的工具链。

代码示例:集成文件系统服务器

from agents.mcp.server import MCPServerStdio

async with MCPServerStdio(

params={

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-filesystem", "/path/to/samples"],

}

) as server:

tools = await server.list_tools()

print(f"可用工具列表:{tools}")

2. 远程HTTP over SSE服务器

通过MCPServerSse类连接远程服务,适用于分布式系统或云原生环境:

-

跨团队协作:多个开发团队共享同一套工具服务。 -

弹性扩展:结合Kubernetes等编排工具实现服务器集群的动态伸缩。

在Agents SDK中集成MCP服务器

代理配置与工具发现

在初始化代理时,通过mcp_servers参数指定需要连接的服务器。SDK会在每次运行代理时自动调用list_tools()获取工具列表,并在模型调用工具时触发call_tool()方法。

代理初始化示例

from agents import Agent

# 定义两个MCP服务器实例

mcp_server_1 = MCPServerStdio(...)

mcp_server_2 = MCPServerSse(...)

agent = Agent(

name="智能助手",

instructions="请使用提供的工具完成任务",

mcp_servers=[mcp_server_1, mcp_server_2]

)

工具缓存优化

频繁调用list_tools()可能导致延迟问题,尤其是在远程服务器场景下。Agents SDK提供了缓存机制:

# 启用工具列表缓存

server = MCPServerSse(

url="https://api.example.com/mcp",

cache_tools_list=True

)

# 手动刷新缓存

server.invalidate_tools_cache()

注意事项:仅在工具列表稳定不变时启用缓存,否则可能导致模型使用过期工具信息。

端到端开发实践:文件搜索代理案例

场景描述

构建一个能够根据用户指令搜索本地文档的代理。该代理需具备以下能力:

-

解析自然语言查询(如“查找2023年财务报告”) -

调用MCP文件系统工具执行关键词搜索 -

返回匹配文件的路径及摘要

实现步骤

-

部署本地MCP服务器 npx -y @modelcontextprotocol/server-filesystem ./documents -

代理配置 async with MCPServerStdio( params={ "command": "npx", "args": ["-y", "@modelcontextprotocol/server-filesystem", "./documents"], } ) as server: agent = Agent( name="文档搜索助手", instructions="使用文件系统工具查找用户请求的文档", mcp_servers=[server] ) -

查询处理 response = await agent.run("请找出包含Q3营收数据的PDF文件") print(response.output)

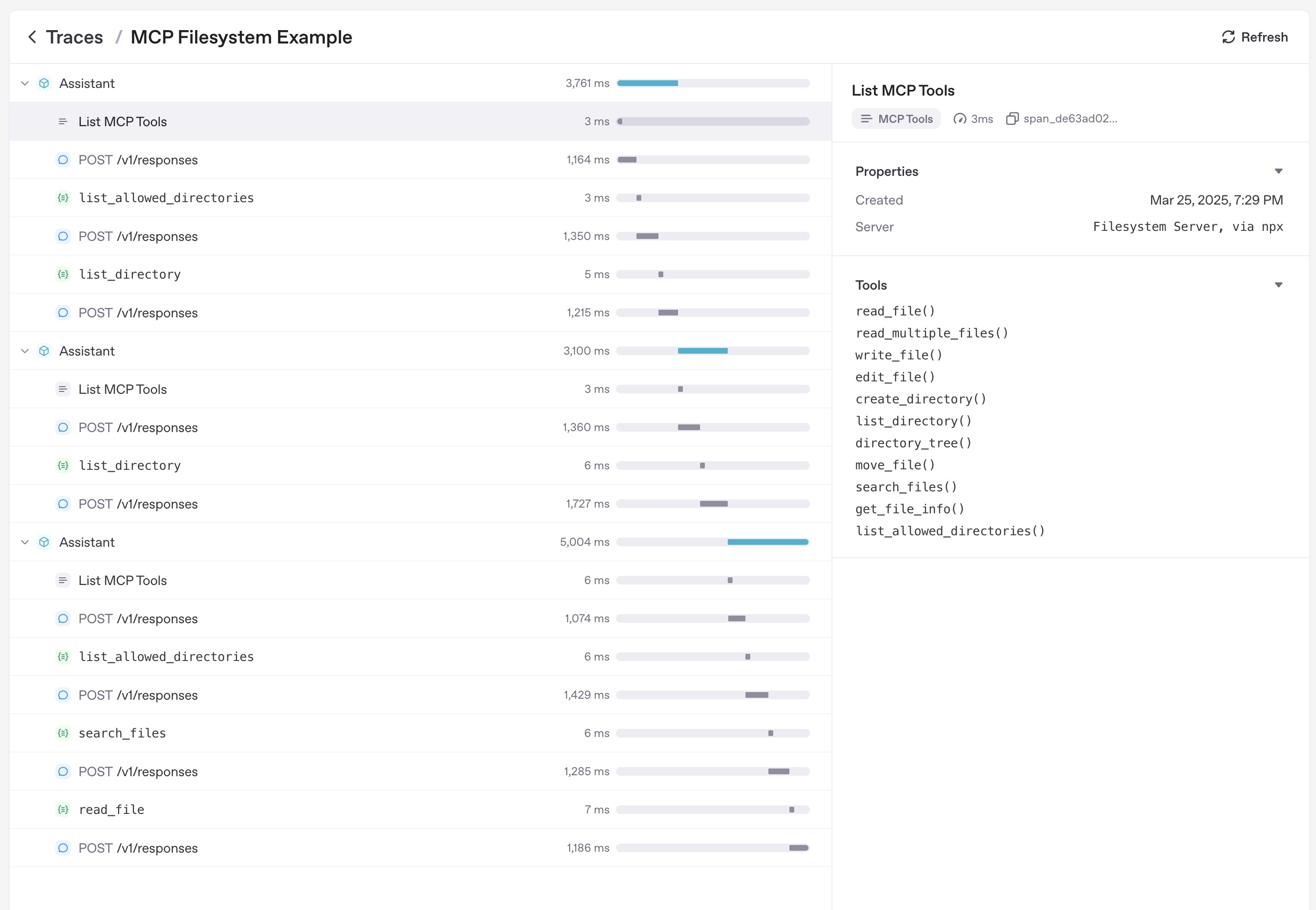

高级功能:追踪与调试

OpenAI Agents SDK内置的追踪系统可实时记录MCP相关操作,包括:

-

工具列表请求的耗时与响应状态 -

每次工具调用的输入参数与返回结果 -

错误堆栈信息(如服务器连接失败)

通过分析追踪数据,开发者可以:

-

识别高频使用的工具,优化服务器资源配置 -

定位权限配置错误导致的工具调用失败 -

分析模型决策链,改进提示词(instructions)设计

最佳实践与常见问题

性能优化建议

-

混合部署模式:将高延迟工具(如外部API)部署为远程服务器,低延迟工具(如本地计算)使用stdio服务器。 -

缓存策略分级:对频繁变更的工具禁用缓存,对稳定工具启用缓存。 -

连接池管理:对于HTTP over SSE服务器,使用长连接减少握手开销。

常见错误排查

-

工具列表为空 -

检查MCP服务器的启动参数是否正确 -

验证服务器是否实现了标准的 list_tools接口

-

-

权限拒绝错误 -

确保文件系统工具的读取路径在服务器白名单中 -

检查远程服务器的CORS配置

-

-

缓存不一致 -

在工具版本更新后调用 invalidate_tools_cache() -

检查服务器时区设置是否与客户端一致

-

扩展资源

通过本文的技术解析与实践指南,开发者可以快速掌握OpenAI Agents SDK与MCP的集成方法,构建更智能、更灵活的AI应用。立即访问GitHub示例库,开启您的上下文增强型代理开发之旅!